Lundi, Sheet Music Platform SoundSlice dit qu’il a développé une nouvelle fonctionnalité après avoir découvert que Chatgpt indiquait à tort que les utilisateurs pouvaient importer la tablature ASCII – un format de notation de guitare basé sur le texte que l’entreprise n’avait jamais pris en charge. L’incident aurait marqué ce qui pourrait être le premier cas d’une fonctionnalité de construction d’entreprise en réponse directe à la confabulation d’un modèle d’IA.

En règle générale, SoundSlice numérise les partitions de photos ou de PDF et synchronise la notation avec des enregistrements audio ou vidéo, permettant aux musiciens de voir la musique défiler pendant qu’ils l’entendent jouer. La plate-forme comprend également des outils pour ralentir la lecture et pratiquer des passages difficiles.

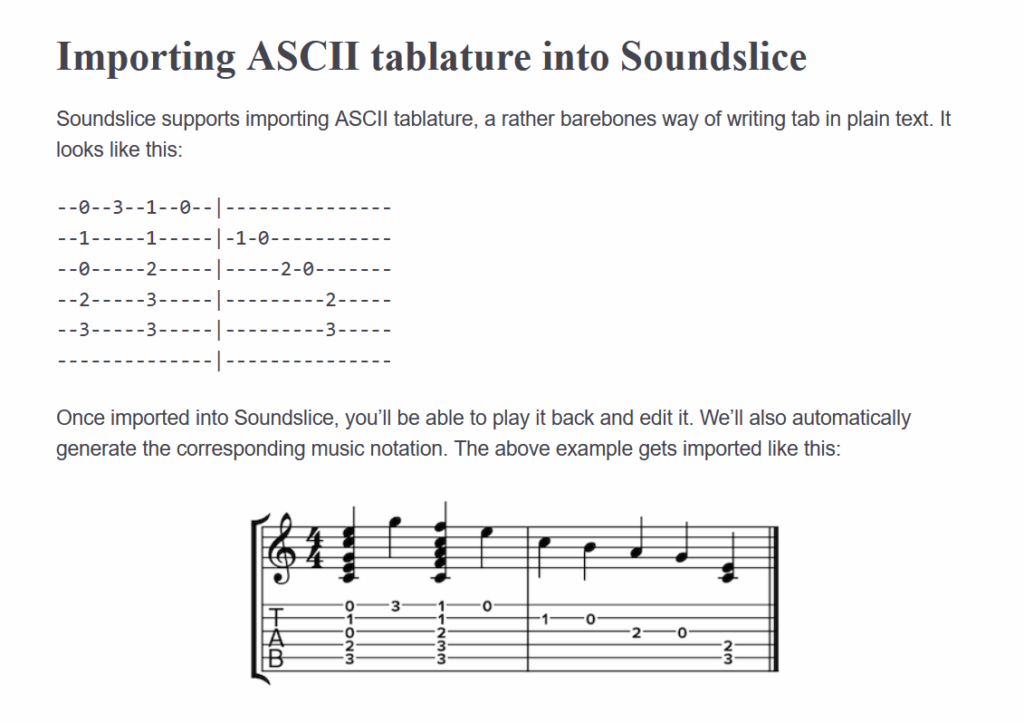

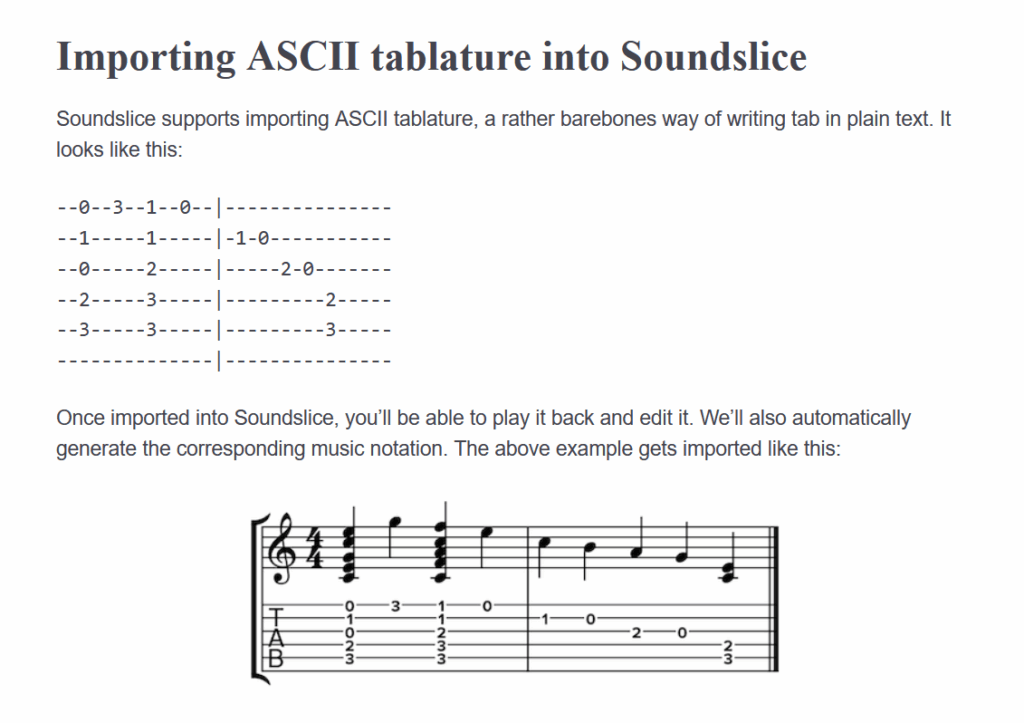

Adrian Holovaty, co-fondatrice de SoundSlice, a écrit dans un article de blog que le récent processus de développement de fonctionnalités a commencé comme un mystère complet. Il y a quelques mois, Holovaty a commencé à remarquer une activité inhabituelle dans les journaux d’erreur de l’entreprise. Au lieu de téléchargements typiques, les utilisateurs soumettaient des captures d’écran de conversations Chatgpt contenant une tablature ASCII – des représentations de texte simples de la musique de guitare qui ressemblent à des chaînes avec des nombres indiquant des positions de frette.

« Notre système de numérisation n’était pas destiné à soutenir ce style de notation », a écrit Holovaty dans le billet de blog. « Pourquoi, alors, étions-nous bombardés avec autant de captures d’écran de Chatgpt Ascii Tab? J’ai été mystifiée pendant des semaines – jusqu’à ce que je me fâche avec moi-même. »

Lorsque Holovaty a testé Chatgpt, il a découvert la source de la confusion: le modèle AI demandait aux utilisateurs de créer des comptes SoundSlice et d’utiliser la plate-forme pour importer des onglets ASCII pour la lecture audio – une fonctionnalité qui n’existait pas. « Nous n’avons jamais soutenu l’onglet ASCII; Chatgpt était carrément mensonge aux gens », a écrit Holovaty, « et nous faisant mal paraître dans le processus, en fixant de fausses attentes à propos de notre service. »

Une capture d’écran de la nouvelle documentation de l’importateur de l’onglet ASCII de Soundlice, hallucinée par Chatgpt et rendu réel plus tard.

Crédit: https://www.soundslice.com/help/en/creating/importing/331/ascii-tab/

Lorsque des modèles d’IA comme Chatgpt génèrent de fausses informations avec une confiance apparente, les chercheurs d’IA l’appellent une «hallucination» ou une «confabulation». Le problème des modèles d’IA confabulation de fausses informations a tourmenté les modèles d’IA depuis la version publique de Chatgpt en novembre 2022, lorsque les gens ont commencé à utiliser par erreur le chatbot en remplacement d’un moteur de recherche.